Grâce au machine learning, une équipe de chercheurs a conçu un logiciel qui permet de calquer les mouvements d’un danseur sur un sujet lambda.

À voir aussi sur Konbini

Vous dansez extrêmement mal mais, allez savoir comment, vous vous êtes retrouvé obligé de vous filmer en train de danser sur un morceau de pop – dans le cadre d’un lip dub, peut-être ? Pauvre de vous — avec l’objectif d’une diffusion grand public de la vidéo ? Ne paniquez pas tout de suite, la science vous couvre.

Le 24 août, The Register partageait les surprenants travaux d’une équipe de chercheurs de l’université de Californie, à Berkeley, qui ont mis au point une technique de transfert des mouvements d’un sujet filmé à un autre. En d’autres termes, une technique qui permettrait à un danseur nul, comme vous, de se faire passer pour un professionnel et de sauver sa e-reputation.

Comment un tel miracle est-il possible ? Grâce à la sorcellerie des réseaux antagonistes génératifs (generative adversarial networks, ou GANs), une méthode d’apprentissage non-supervisée dans laquelle deux algorithmes sont placés l’un “face à l’autre”. Le premier génère des images avec l’objectif de les rendre le plus réalistes possible, tandis que l’autre a pour mission d’identifier si l’image est réelle ou artificielle. Le calcul s’arrête lorsque l’algorithme générateur a réussi à tromper la vigilance de l’algorithme d’identification.

C’est à cette technique qu’on doit les désormais fameux deepfakes, ces fausses vidéos (malheureusement) plus vraies que nature, nées en 2016 et popularisées début 2017 avec la mise à disposition des logiciels spécialisés, qui permettent de placer le visage de quelqu’un dans n’importe quelle vidéo (ce qui a déjà conduit à une nouvelle espèce de revenge porn) ou de faire dire n’importe quoi à n’importe qui dans une fausse vidéo (au hasard, un ex-président américain), dès lors qu’on fournit au logiciel un échantillon de quelques secondes de la personne ciblée.

Une technique de désinformation extrêmement efficace, alors que les premières solutions anti-deepfakes commencent seulement à émerger, notamment développées par la Defense Advanced Research Projects Agency (Darpa), le département de recherche de l’armée américaine.

Des résultats convaincants… et potentiellement effrayants

Bon, dans votre cas, les enjeux sont beaucoup moins élevés, puisqu’il ne s’agit que de vous éviter une humiliation publique. Voilà comment la méthode fonctionne : trouvez-vous un danseur, et filmez-le sur la musique de votre choix. Répétez l’opération, si possible dans le même cadre, avec vous. Réalisez que vous ne savez absolument pas coordonner vos mouvements, puis souvenez-vous que ça n’aura bientôt plus d’importance.

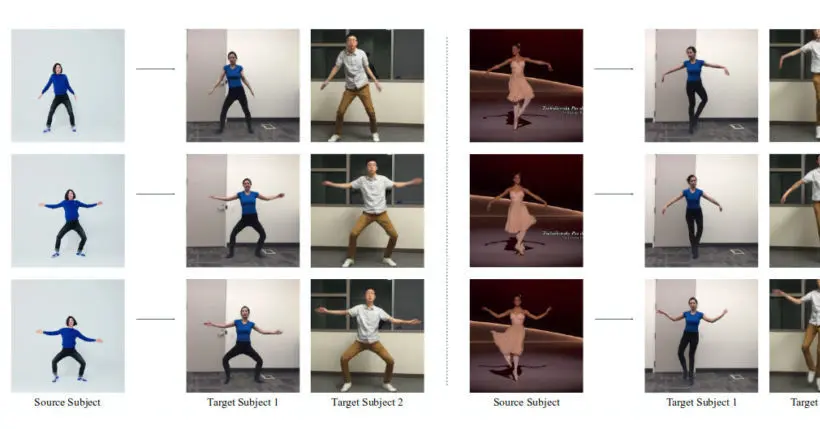

Lorsque vous fournissez au logiciel les deux vidéos, celui-ci va opérer le transfert de mouvements en plusieurs étapes : un premier logiciel va identifier les mouvements du danseur en modélisant sa silhouette en bâtons, avant d’appliquer la texture de votre corps sur cette silhouette animée, en la rendant de plus en plus réaliste.

Une fois le corps modélisé, un autre algorithme entrera en action pour s’atteler spécifiquement à placer votre visage et vos expressions faciales de manière réaliste sur les mouvements du danseur. Après tout, ce serait quand même dommage qu’on se rende compte que vous avez falsifié votre lip dub.

Pour le moment, les résultats sont plutôt convaincants, même si loin d’atteindre un niveau de réalisme capable de flouer le grand public. Sur la vidéo, les bras et les jambes du sujet-cible ont une texture… étrange, presque caoutchouteuse, et son expression faciale est celle d’un cyborg. Le réalisme attendra encore un peu… et c’est tant mieux.

Comme le rappelle The Register, jamais le dernier quand il s’agit de cynisme, si un algorithme parvient à créer des deepfakes avec des enchaînements de mouvements aussi complexes que ceux d’un danseur, alors la même méthode est transposable à presque n’importe quelle activité.

Imaginez maintenant une vidéo de vous, générée par ce type de méthode, dans laquelle on vous voit sniffer de la coke, commettre un braquage à main armée ou tabasser un manifestant, par exemple… Pour nous éviter une dystopie de la post-vérité, les anti-deepfakes vont devoir sérieusement progresser.