Google DeepMind, déjà conceptrice d’AlphaGo, a effectué de nouvelles expériences avec son IA. Cette fois-ci, c’est un parcours d’obstacles.

À voir aussi sur Konbini

Ce qu’il y a de beau avec l’actualité de l’intelligence artificielle, c’est que le progrès, si extraordinaire, si terrifiant soit-il, se pare souvent de ridicule. Les IA progressent à une vitesse formidable et exponentielle, mais elles partent de si loin qu’elles sont encore régulièrement ridicules. D’un côté, c’est toujours agréable à regarder en plein milieu d’une journée de boulot en juillet, de l’autre, on ne peut s’empêcher de se demander si l’on n’est pas en train de se foutre de la gueule du prochain grand prédateur de l’espèce humaine, et ça prend du coup une tournure un peu angoissante. Rire de l’IA, c’est un peu comme faire mumuse avec un lionceau : c’est drôle, jusqu’à ce que ça nous tue en une fraction de seconde.

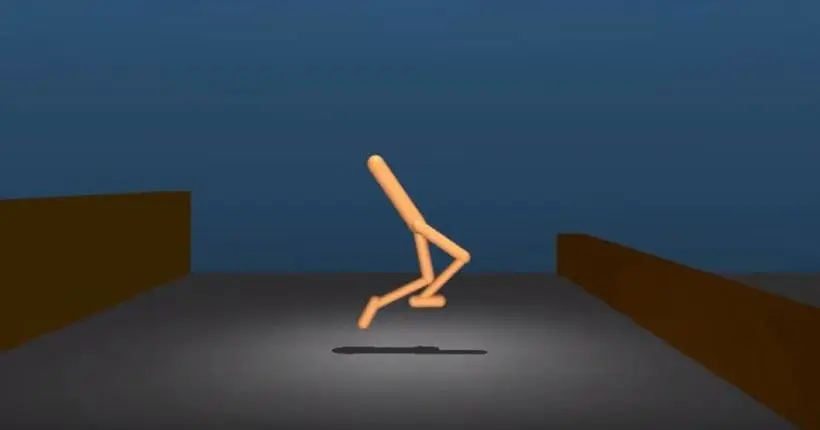

Pourtant, difficile de résister à la lecture et au visionnage des derniers résultats de DeepMind, la filiale de Google spécialisée dans le développement de l’IA et déjà responsable d’AlphaGo. Comme le rapporte The Verge, l’entreprise a cette fois-ci décidé d’apprendre à un algorithme à faire du parkour en la dotant d’un corps et en lui ordonnant d’éviter tout un tas d’obstacles. En vidéo, ça donne une sorte de stickman manchot couleur Knacki, qui évite des plateformes à grandes enjambées gauches, quand il ne s’autorise pas un bon vieux limbo.

Rigolez, mais ça fonctionne, et c’est une vraie prouesse. Les résultats, publiés sur arXiv, sont fondamentaux pour le développement d’une IA autonome, capable de s’adapter à tout environnement sans être obligée de passer par la case empirisme en se plantant quinze fois avant de réussir à contourner un obstacle. C’est grâce à ce genre de travaux que dans quelques années, votre robot domestique pourra se balader sans effort dans votre maison et vous suivre partout où vous allez en se déplaçant exactement comme vous.

Le “bon sens”, graal de la recherche

Plus précisément, l’étude explore les limites du reinforcement learning, l’une des méthodes d’apprentissage de l’IA actuelle dite “stochastique”, conçue pour gérer des variables aléatoires. Dans cette optique, les chercheurs dotent l’IA d’un “corps” virtuel, de senseurs pour percevoir son propre volume et ses mouvements ainsi que les dimensions, formes et règles physiques qui régissent son monde, et lui ordonnent d’aller tout droit. Évidemment, au premier obstacle, la machine se plante lamentablement, puis recommence jusqu’à ce qu’elle y arrive, un peu comme si vous caliez un enfant devant Super Mario Bros.

Le problème avec cette technique est qu’elle ne permet pas à la machine d’avoir des connaissances générales sur la manière de passer des obstacles, mais seulement des connaissances adaptées à une situation particulière. Par analogie, votre enfant devant sa console finira peut-être par terminer le premier niveau de Super Mario après plusieurs heures d’effort et quelques milliers de vies cramées, mais toute cette connaissance accumulée ne lui servira plus à rien au deuxième niveau. Grâce à cette étude, les ingénieurs de DeepMind ont prouvé qu’il était possible d’inculquer aux algorithmes des connaissances générales de mouvements complexes avec le reinforcement learning.

Pourquoi est-ce important ? Car ce que nous appelons le “bon sens” – ce qui fait qu’une fois que vous savez vous servir d’un marteau par exemple, vous savez vous servir de tous les marteaux, peu importe leur forme ou leur couleur – manque cruellement aux IA, même les plus avancées. AlphaGo est peut-être devenu le meilleur joueur de go de l’histoire, mais mettez-le sur un autre jeu de stratégie et il vous sera parfaitement inutile. La capacité de réutiliser des connaissances et de les transposer dans différentes situations est donc une véritable avancée dans le secteur – une de plus –, et l’écart entre l’intelligence humaine et l’intelligence artificielle se réduit encore d’un cran, même s’il est infinitésimal. Rira bien qui rira le dernier.