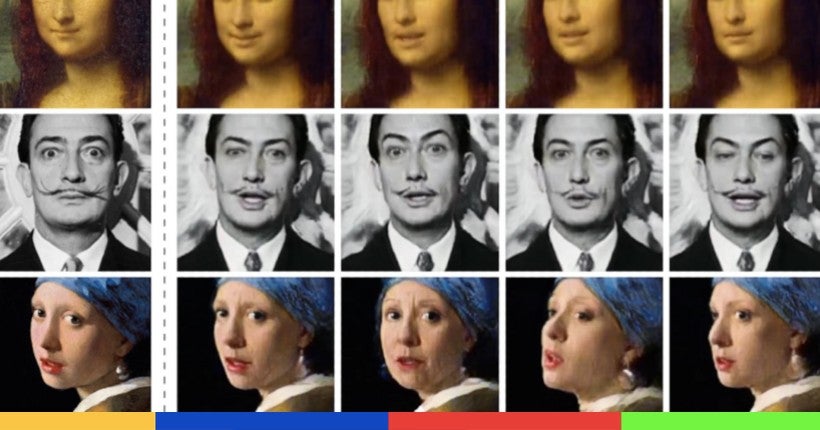

Un deepfake, c’est une vidéo truquée, où le visage d’une personne a été interverti avec celui d’une autre, généralement connue, parfois dans une intention humoristique, parfois pour faire du porno sexiste, mais bien souvent dans l’intention de lui nuire ou de propager de fausses rumeurs. Comment se fabrique un deepfake ? Nous avions fait le test avec Kaaris !

Publicité

Des années après leur apparition sur des forums réservés aux initiés comme Reddit ou 4chan, leur potentiel de désinformation s’est accru avec leur prolifération sur les réseaux sociaux et plateformes plus mainstream, comme Facebook ou YouTube.

Publicité

Et, à l’approche des élections présidentielles de novembre aux États-Unis, leur existence semble plus problématique que jamais. Car même si peu de deepfakes sont vraiment convaincants, et que la plupart sont détectables à l’œil nu, on redoute que leur prolifération amène les électeurs à douter de la crédibilité des autres vidéos officielles.

Aussi n’est-il pas étonnant que ces capsules trafiquées continuent d’angoisser les amoureux de la vérité : il n’existe encore aucune méthode, ni humaine, ni informatique, pour les détecter rapidement et endiguer leur propagation.

Publicité

Le Deepfake Detection Challenge

Pour contrer ce fléau, en 2019, l’entreprise de Mark Zuckerberg avait lancé le Deepfake Detection Challenge : une compétition pour faire émerger des solutions de détection automatique de deepfake. Microsoft, Amazon, Facebook et de grandes universités comme le MIT, Oxford, Cornwall et l’Université de Californie à Berkeley avaient participé au lancement.

Facebook avait tourné avec 3 500 vrais acteurs (en prenant bien soin d’avoir leur visage) avec une diversité de profils : âge, sexe et couleur de peau. À partir de ces enregistrements, 100 000 vidéos ont été générées. Une bonne partie d’entre elles ont été transformées en deepfakes par les organisateurs du concours.

Publicité

Autrement dit, il s’agissait de construire le plus grand dataset de deepfakes, ensemble de données nécessaires pour entraîner une intelligence artificielle à les détecter. Mises bout à bout, ces vidéos duraient 3 jours et demi ! Ensuite, les 2 114 participants du concours ont développé leurs propres algorithmes pour analyser ces 100 000 vidéos, s’entraîner, et repérer les manipulations.

Facebook vient de publier les résultats. Le grand vainqueur, dont l’IA s’est mesurée à 10 000 vidéos qu’elle n’avait jamais visionnées auparavant, se nomme Selim Seferbekov. Son IA a atteint un taux de détection de deepfakes de 65,18 %. Si le résultat n’est pas encore assez satisfaisant pour être largement utilisé sur le Web, il reste plutôt encourageant, et participe au progrès pressant de cette technologie.

Publicité

Faire avancer les outils de détection

Nos yeux sont encore les meilleurs pour repérer les deepfakes, et les algorithmes essaient de les copier. Comme nous, ils recherchent des anomalies qui seraient perceptibles à l’œil nu. Mais pour l’heure, ils ne s’intéressent pas encore aux traces de modification dans le code source de la vidéo ou encore le contexte de publication ne comptent pas, ou pas assez.

D’ailleurs, comme le souligne Selim Seferbekov, pour l’instant, le moyen le plus sûr d’identifier un deepfake est de rester attentif aux légers clignotements entre deux mouvements du visage, et non d’analyser le fichier vidéo en soi.

Publicité

L’entreprise vient de rendre publiques les 100 000 vidéos du dataset : “Cela aidera les chercheurs en IA à développer une nouvelle génération de méthodes de détection pour faire avancer l’état de la recherche dans ce domaine”, a avancé un porte-parole de Facebook lors d’une conférence de presse à destination des journalistes américains.

Les algorithmes gagnants seront mis à disposition en open source. Facebook, en revanche, a annoncé que ses propres algorithmes de lutte contre les fake news resteraient confidentiels ; dévoiler ses recettes de publication pourrait donner lieu à du reverse engineering, autrement dit permettre aux créateurs de deepfakes de mieux connaître le super-bouclier… et le contourner.